以下部分将重点介绍常见的虚拟化任务,并解释有关主机管理和管理的 Proxmox VE 细节。

Proxmox VE 基于Debian GNU/Linux,并带有附加存储库来提供 Proxmox VE 相关软件包。这意味着可以使用全系列 Debian 软件包,包括安全更新和错误修复。Proxmox VE基于Ubuntu内核提供了自己的Linux内核。它启用了所有必要的虚拟化和容器功能,并包括 ZFS和几个额外的硬件驱动程序。

对于以下部分中未包含的其他主题,请参阅 Debian 文档。Debian 管理员手册可 在线获取,并提供对 Debian 操作系统的全面介绍(请参阅[Hertzog13])。

3.1. 包存储库

与任何其他基于 Debian 的系统一样,Proxmox VE 使用APT作为其包管理工具。

3.1.1. Proxmox VE 中的存储库

存储库是软件包的集合,它们可用于安装新软件,但对于获取新更新也很重要。

| 您需要有效的 Debian 和 Proxmox 存储库才能获取最新的安全更新、错误修复和新功能。 |

APT 存储库在文件/etc/apt/sources.list和/etc/apt/sources.list.d/中的.list 文件中定义。

存储库管理

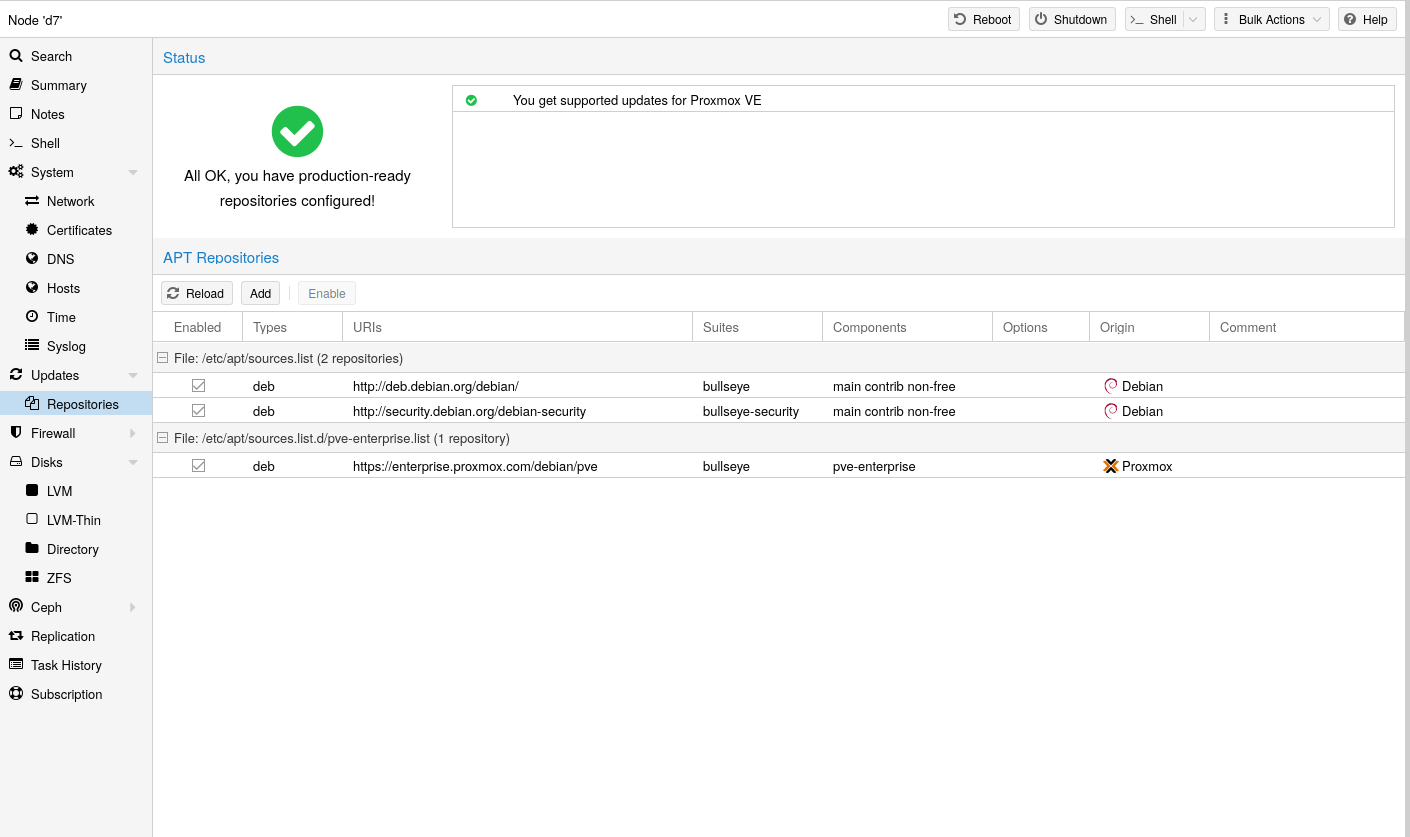

从 Proxmox VE 7 开始,您可以在 Web 界面中检查存储库状态。节点摘要面板显示高级状态概述,而单独的 存储库面板显示所有已配置存储库的深入状态和列表。

还支持基本存储库管理,例如激活或停用存储库。

来源.list

在sources.list文件中,每一行都定义一个包存储库。首选来源必须放在第一位。空行将被忽略。行中任意位置的#字符将该行的其余部分标记为注释。通过运行apt-get update获取存储库中的可用包。可以使用apt-get直接安装更新,或通过 GUI(节点 → 更新)安装更新。文件

/etc/apt/sources.listdeb http://deb.debian.org/debian bookworm 主要贡献 deb http://deb.debian.org/debian bookworm-updates 主要贡献 # 安全更新 deb http://security.debian.org/debian-security bookworm-security 主要贡献

Proxmox VE 提供了三种不同的软件包存储库。

3.1.2. Proxmox VE 企业存储库

这是默认、稳定且推荐的存储库,可供所有 Proxmox VE 订阅用户使用。它包含最稳定的软件包,适合生产使用。pve -enterprise存储库默认启用:文件

/etc/apt/sources.list.d/pve-enterprise.listdeb https://enterprise.proxmox.com/debian/pve 书虫 pve-enterprise

root @pam用户会收到有关可用更新的电子邮件通知。单击 GUI 中的“更改日志”按钮可查看有关所选更新的更多详细信息。

您需要有效的订阅密钥才能访问pve-enterprise存储库。提供不同的支持级别。更多详细信息请访问 https://www.proxmox.com/en/proxmox-ve/pricing。

| 您可以通过使用#(在行开头)注释掉上面的行来禁用此存储库 。如果您的主机没有订阅密钥,这可以防止出现错误消息。 在这种情况下,请配置pve-no-subscription存储库。 |

3.1.3. Proxmox VE 无订阅存储库

这是推荐用于测试和非生产用途的存储库。它的包没有经过严格的测试和验证。您不需要订阅密钥即可访问pve-no-subscription存储库。

我们建议在/etc/apt/sources.list中配置此存储库。文件

/etc/apt/sources.listdeb http://ftp.debian.org/debian bookworm 主要贡献 deb http://ftp.debian.org/debian bookworm-updates 主要贡献 # Proxmox VE pve-no-subscription 存储库由 proxmox.com 提供, # 不推荐用于生产用途 deb http://download.proxmox.com/debian/pve 书虫 pve-no-subscription # 安全更新 deb http://security.debian.org/debian-security bookworm-security 主要贡献

3.1.4. Proxmox VE 测试存储库

该存储库包含最新的软件包,主要供开发人员测试新功能。要配置它,请将以下行添加到 /etc/apt/sources.list:pvetest的 resources.list 条目deb http://download.proxmox.com/debian/pve 书虫 pvetest

| pvetest存储库应该(顾名思义)仅用于测试新功能或错误修复。 |

3.1.5。Ceph 昆西企业存储库

该存储库包含企业 Proxmox VE Ceph Quincy 软件包。它们适合生产。如果您在 Proxmox VE 上运行 Ceph 客户端或完整的 Ceph 集群,请使用此存储库。文件

/etc/apt/sources.list.d/ceph.listdeb https://enterprise.proxmox.com/debian/ceph-quincy 书虫企业

3.1.6。Ceph Quincy 无订阅存储库

此 Ceph 存储库包含 Ceph Quincy 包在移动到企业存储库之前以及移动到测试存储库之后的情况。

| 建议对生产计算机使用企业存储库。 |

文件

/etc/apt/sources.list.d/ceph.listdeb http://download.proxmox.com/debian/ceph-quincy 书虫无订阅

3.1.7. Ceph 昆西测试存储库

此 Ceph 存储库包含 Ceph Quincy 包,然后将其移动到主存储库。它用于在 Proxmox VE 上测试新的 Ceph 版本。文件

/etc/apt/sources.list.d/ceph.listdeb http://download.proxmox.com/debian/ceph-quincy 书虫测试

3.1.8. 较旧的 Ceph 存储库

Proxmox VE 8 不支持 Ceph Pacific、Ceph Octopus,甚至不支持超融合设置的旧版本。对于这些版本,您需要先将 Ceph 升级到更新版本,然后再升级到 Proxmox VE 8。

详细信息请参阅相应的 升级指南。

3.1.9. 安全应用程序

存储库中的发布文件是用 GnuPG 签名的。APT 使用这些签名来验证所有包是否来自可信来源。

如果您从官方 ISO 映像安装 Proxmox VE,则已经安装了用于验证的密钥。

如果您在 Debian 上安装 Proxmox VE,请使用以下命令下载并安装密钥:# wget https://enterprise.proxmox.com/debian/proxmox-release-bookworm.gpg -O /etc/apt/trusted.gpg.d/proxmox-release-bookworm.gpg

之后使用sha512sum CLI 工具验证校验和:# sha512sum /etc/apt/trusted.gpg.d/proxmox-release-bookworm.gpg 7da6fe34168adc6e479327ba517796d4702fa2f8b4f0a9833f5ea6e6b48f6507a6da403a274fe201595edc86a84463d50383d07f64bdde2e3658108db7d6dc87 /etc/apt/ trust.gpg.d/proxmox-release-bookworm.gpg

或md5sum CLI 工具:# md5sum /etc/apt/trusted.gpg.d/proxmox-release-bookworm.gpg 41558dc019ef90bd0f6067644a51cf5b /etc/apt/trusted.gpg.d/proxmox-release-bookworm.gpg

3.2. 系统软件更新

Proxmox 定期为所有存储库提供更新。要安装更新,请使用基于 Web 的 GUI 或以下 CLI 命令:# apt-get 更新 # apt-get dist-upgrade

| APT 包管理系统非常灵活,并提供许多功能,请参阅man apt-get或[Hertzog13]了解更多信息。 |

| 定期更新对于获取最新补丁和安全相关修复至关重要。主要系统升级已在Proxmox VE 社区论坛中公布。 |

3.3. 网络配置

Proxmox VE 使用 Linux 网络堆栈。这为如何在 Proxmox VE 节点上设置网络提供了很大的灵活性。配置可以通过 GUI 完成,也可以通过手动编辑文件/etc/network/interfaces来完成,其中包含整个网络配置。Interfaces (5)手册页包含完整的格式描述。所有 Proxmox VE 工具都尽力保留用户的直接修改,但使用 GUI 仍然更好,因为它可以保护您免受错误的影响。

需要一个vmbr接口将来宾连接到底层物理网络。它们是一个 Linux 桥接器,可以将其视为连接来宾和物理接口的虚拟交换机。本节提供了一些示例,说明如何设置网络以适应不同的用例,例如通过bond、 vlan或 路由和 NAT设置实现冗余。

软件定义网络是 Proxmox VE 集群中更复杂虚拟网络的一个选项。

| 如果不确定,不鼓励使用传统的 Debian 工具ifup和ifdown ,因为它们有一些缺陷,例如中断 ifdown vmbrX上的所有来宾流量,但稍后在同一网桥上执行ifup时不会再次重新连接这些来宾。 |

3.3.1. 应用网络更改

Proxmox VE 不会直接将更改写入/etc/network/interfaces。相反,我们写入一个名为/etc/network/interfaces.new的临时文件,这样您就可以一次进行许多相关的更改。这还可以确保您的更改在应用之前是正确的,因为错误的网络配置可能会导致节点无法访问。

使用 ifupdown2 实时重新加载网络

使用推荐的ifupdown2软件包(自 Proxmox VE 7.0 起新安装的默认设置),无需重新启动即可应用网络配置更改。如果通过 GUI 更改网络配置,则可以单击 “应用配置”按钮。这会将更改从暂存 Interfaces.new文件移动到/etc/network/interfaces并实时应用它们。

如果您直接对/etc/network/interfaces文件进行手动更改,则可以通过运行ifreload -a应用它们

| 如果您在 Debian 之上安装了 Proxmox VE,或者从较旧的 Proxmox VE 安装升级到 Proxmox VE 7.0,请确保安装了ifupdown2 : apt install ifupdown2 |

重启节点即可应用

应用新网络配置的另一种方法是重新启动节点。在这种情况下,systemd 服务pvenetcommit将在网络服务应用该配置之前激活暂存 Interfaces.new文件。

3.3.2. 命名约定

目前,我们对设备名称使用以下命名约定:

- 以太网设备:en*、systemd 网络接口名称。自版本 5.0 起,此命名方案用于新的 Proxmox VE 安装。

- 以太网设备:eth[N],其中 0 ≤ N ( eth0 , eth1 , …) 此命名方案用于在 5.0 版本之前安装的 Proxmox VE 主机。升级到 5.0 时,名称保持原样。

- 桥名称:vmbr[N],其中 0 ≤ N ≤ 4094 ( vmbr0 – vmbr4094 )

- 键:键 [N],其中 0 ≤ N ( bond0 , bond1 , …)

- VLAN:只需将 VLAN 编号添加到设备名称中,并用句点分隔(eno1.50、bond1.30)

这使得调试网络问题变得更加容易,因为设备名称暗示了设备类型。

Systemd 网络接口名称

Systemd对以太网网络设备使用两个字符前缀en 。接下来的字符取决于设备驱动程序以及模式首先匹配的事实。

- o<index>[n<phys_port_name>|d<dev_port>] — 板上设备

- s<slot>[f<function>][n<phys_port_name>|d<dev_port>] — 按热插拔 ID 的设备

- [P<domain>]p<bus>s<slot>[f<function>][n<phys_port_name>|d<dev_port>] — 按总线 ID 划分的设备

- x<MAC> — 按 MAC 地址的设备

最常见的模式是:

- eno1 — 是第一个板载 NIC

- enp3s0f1 — 是 pcibus 3 插槽 0 上的 NIC,并使用 NIC 功能 1。

有关详细信息,请参阅可预测的网络接口名称。

3.3.3. 选择网络配置

根据您当前的网络组织和资源,您可以选择桥接、路由或伪装网络设置。

私有 LAN 中的 Proxmox VE 服务器,使用外部网关访问互联网

在这种情况下,桥接模型最有意义,这也是新 Proxmox VE 安装的默认模式。您的每个来宾系统都会有一个连接到 Proxmox VE 桥的虚拟接口。这实际上类似于将访客网卡直接连接到 LAN 上的新交换机,Proxmox VE 主机扮演交换机的角色。

托管提供商处的 Proxmox VE 服务器,为来宾提供公共 IP 范围

对于此设置,您可以使用桥接或路由模型,具体取决于您的提供商允许的模式。

托管提供商处的 Proxmox VE 服务器,具有单个公共 IP 地址

在这种情况下,获得来宾系统的传出网络访问权限的唯一方法是使用Masquerading。对于访客的传入网络访问,您需要配置端口转发。

为了获得更大的灵活性,您可以配置 VLAN (IEEE 802.1q) 和网络绑定(也称为“链路聚合”)。这样就可以构建复杂且灵活的虚拟网络。

3.3.4. 使用网桥的默认配置

网桥就像用软件实现的物理网络交换机。所有虚拟来宾可以共享一个网桥,或者您可以创建多个网桥来分隔网络域。每个主机最多可以有 4094 个网桥。

安装程序创建一个名为vmbr0的网桥,该网桥连接到第一个以太网卡。/etc/network/interfaces中的相应配置可能如下所示:自动定位 iface lo inet环回 iface eno1 inet 手册 自动虚拟机BR0 iface vmbr0 inet 静态 地址192.168.10.2/24 网关192.168.10.1 桥接端口 eno1 桥接 stp 关闭 桥FD 0

虚拟机的行为就像直接连接到物理网络一样。反过来,网络将每个虚拟机视为拥有自己的 MAC,即使只有一根网络电缆将所有这些虚拟机连接到网络。

3.3.5. 路由配置

大多数托管提供商不支持上述设置。出于安全原因,一旦在单个接口上检测到多个 MAC 地址,他们就会禁用网络。

| 一些提供商允许您通过其管理界面注册额外的 MAC。这可以避免这个问题,但配置起来可能很笨拙,因为您需要为每个虚拟机注册一个 MAC。 |

您可以通过单个接口“路由”所有流量来避免该问题。这可确保所有网络数据包使用相同的 MAC 地址。

一种常见的情况是您有一个公共 IP(本例中假设为198.51.100.5 ),以及一个用于 VM 的附加 IP 块 ( 203.0.113.16/28 )。对于此类情况,我们建议采用以下设置:自动定位 iface lo inet环回 自动 eno0 iface eno0 inet 静态 地址198.51.100.5/29 网关198.51.100.1 后回显 1 > /proc/sys/net/ipv4/ip_forward 后回显 1 > /proc/sys/net/ipv4/conf/eno0/proxy_arp 自动虚拟机BR0 iface vmbr0 inet 静态 地址203.0.113.17/28 桥接端口 无 桥接 stp 关闭 桥FD 0

3.3.6. 使用iptables进行伪装 (NAT)

伪装允许只有私有 IP 地址的访客通过使用主机 IP 地址进行传出流量来访问网络。每个传出数据包都会被iptables重写,以显示为源自主机,并且响应也会相应地重写以路由到原始发送者。自动定位 iface lo inet环回 自动 eno1 #真实IP地址 iface eno1 inet 静态 地址198.51.100.5/24 网关198.51.100.1 自动虚拟机BR0 #私有子网 iface vmbr0 inet 静态 地址10.10.10.1/24 桥接端口 无 桥接 stp 关闭 桥FD 0 后回显 1 > /proc/sys/net/ipv4/ip_forward post-up iptables -t nat -A POSTROUTING -s ‘10.10.10.0/24’ -o eno1 -j MASQUERADE post-down iptables -t nat -D POSTROUTING -s ‘10.10.10.0/24’ -o eno1 -j MASQUERADE

| 在某些启用防火墙的伪装设置中,传出连接可能需要 conntrack 区域。否则,防火墙可能会阻止传出连接,因为它们更喜欢VM 桥的 POSTROUTING (而不是MASQUERADE)。 |

在/etc/network/interfaces中添加这些行可以解决此问题:post-up iptables -t raw -I PREROUTING -i fwbr+ -j CT –zone 1 post-down iptables -t raw -D PREROUTING -i fwbr+ -j CT –zone 1

有关此内容的更多信息,请参阅以下链接:

netdev-list 上的补丁引入了 conntrack 区域

3.3.7. Linux债券

绑定(也称为 NIC 组合或链路聚合)是将多个 NIC 绑定到单个网络设备的技术。可以实现不同的目标,例如使网络具有容错能力、提高性能或两者兼而有之。

光纤通道等高速硬件以及相关的交换硬件可能非常昂贵。通过进行链路聚合,两个 NIC 可以显示为一个逻辑接口,从而实现双倍速度。这是大多数交换机都支持的本机 Linux 内核功能。如果您的节点有多个以太网端口,您可以通过将网络电缆连接到不同的交换机来分布故障点,并且在出现网络故障时,绑定连接将故障转移到一根电缆或另一根电缆。

聚合链接可以改善实时迁移延迟并提高 Proxmox VE 集群节点之间的数据复制速度。

有 7 种绑定模式:

- 循环 (balance-rr):从第一个可用网络接口 (NIC) 从站到最后一个按顺序传输网络数据包。该模式提供负载平衡和容错。

- Active-backup(主动备份):绑定中只有一个 NIC Slave 处于活动状态。当且仅当活动从站发生故障时,另一个从站才会变为活动状态。单个逻辑绑定接口的 MAC 地址仅在一个 NIC(端口)上外部可见,以避免网络交换机中的失真。该模式提供容错能力。

- XOR (balance-xor):基于[(源 MAC 地址与目标 MAC 地址异或)模 NIC 从属计数] 传输网络数据包。这将为每个目标 MAC 地址选择相同的 NIC 从属设备。该模式提供负载平衡和容错。

- Broadcast(广播):在所有从网络接口上传输网络数据包。该模式提供容错能力。

- IEEE 802.3ad 动态链路聚合 (802.3ad)(LACP):创建共享相同速度和双工设置的聚合组。根据 802.3ad 规范利用活动聚合器组中的所有从属网络接口。

- 自适应传输负载平衡(balance-tlb): Linux 绑定驱动程序模式,不需要任何特殊的网络交换机支持。传出网络数据包流量根据每个网络接口从属设备上的当前负载(相对于速度计算)进行分配。传入流量由当前指定的从属网络接口接收。如果此接收从站发生故障,则另一个从站将接管发生故障的接收从站的 MAC 地址。

- 自适应负载平衡(balance-alb):包括balance-tlb以及IPV4流量的接收负载平衡(rlb),并且不需要任何特殊的网络交换机支持。接收负载均衡是通过ARP协商实现的。绑定驱动程序拦截本地系统发送的 ARP 应答,并使用单个逻辑绑定接口中的 NIC 从属设备之一的唯一硬件地址覆盖源硬件地址,以便不同的网络对等方使用不同的 MAC 地址他们的网络数据包流量。

如果您的交换机支持 LACP (IEEE 802.3ad) 协议,那么我们建议使用相应的绑定模式 (802.3ad)。否则,您通常应该使用主动备份模式。

对于集群网络 (Corosync),我们建议将其配置为多个网络。Corosync 不需要网络冗余绑定,因为如果网络不可用,它可以自行在网络之间切换。

以下绑定配置可用作分布式/共享存储网络。好处是您可以获得更快的速度并且网络具有容错能力。示例:使用具有固定 IP 地址的 bond自动定位 iface lo inet环回 iface eno1 inet 手册 iface eno2 inet 手册 iface eno3 inet 手册 自动粘合0 iface bond0 inet 静态 债券奴隶 eno1 eno2 地址192.168.1.2/24 债券-米蒙 100 绑定模式 802.3ad bond-xmit-hash-policy 层 2+3 自动虚拟机BR0 iface vmbr0 inet 静态 地址10.10.10.2/24 网关10.10.10.1 桥接端口 eno3 桥接 stp 关闭 桥FD 0

另一种可能性是直接使用绑定作为桥接端口。这可用于使访客网络具有容错能力。示例:使用绑定作为桥接端口自动定位 iface lo inet环回 iface eno1 inet 手册 iface eno2 inet 手册 自动粘合0 iface bond0 inet 手册 债券奴隶 eno1 eno2 债券-米蒙 100 绑定模式 802.3ad bond-xmit-hash-policy 层 2+3 自动虚拟机BR0 iface vmbr0 inet 静态 地址10.10.10.2/24 网关10.10.10.1 桥接端口 bond0 桥接 stp 关闭 桥FD 0

3.3.8. VLAN 802.1Q

虚拟局域网(VLAN)是在网络的第二层划分和隔离的广播域。因此,一个物理网络中可以有多个网络(4096),每个网络彼此独立。

每个 VLAN 网络都由一个通常称为标记的数字来标识。然后对网络包进行标记以识别它们属于哪个虚拟网络。

访客网络的 VLAN

Proxmox VE 开箱即用地支持此设置。您可以在创建虚拟机时指定 VLAN 标记。VLAN 标记是访客网络配置的一部分。网络层支持不同的模式来实现 VLAN,具体取决于网桥配置:

- Linux 桥上的 VLAN 感知: 在这种情况下,每个来宾的虚拟网卡都被分配一个 VLAN 标记,Linux 桥透明地支持该标记。中继模式也是可能的,但这使得在来宾中进行配置是必要的。

- Linux 网桥上的“传统”VLAN: 与 VLAN 感知方法相比,此方法不是透明的,它会为每个 VLAN 创建一个具有关联网桥的 VLAN 设备。也就是说,例如,在 VLAN 5 上创建访客将创建两个接口 eno1.5 和 vmbr0v5,这两个接口将一直保留到重新启动为止。

- Open vSwitch VLAN: 该模式使用OVS VLAN功能。

- 访客配置的 VLAN: VLAN 在访客内部分配。在这种情况下,设置完全在来宾内部完成,不会受到外部的影响。好处是您可以在单个虚拟 NIC 上使用多个 VLAN。

主机上的 VLAN

允许主机与隔离网络进行通信。可以将 VLAN 标记应用于任何网络设备(NIC、Bond、Bridge)。一般来说,您应该在与物理网卡之间抽象层最少的接口上配置 VLAN。

例如,在默认配置中,您希望将主机管理地址放置在单独的 VLAN 上。示例:使用 VLAN 5 作为带有传统 Linux 网桥的 Proxmox VE 管理 IP自动定位 iface lo inet环回 iface eno1 inet 手册 iface eno1.5 inet手册 自动 vmbr0v5 iface vmbr0v5 inet 静态 地址10.10.10.2/24 网关10.10.10.1 桥接端口 eno1.5 桥接 stp 关闭 桥FD 0 自动虚拟机BR0 iface vmbr0 inet 手册 桥接端口 eno1 桥接 stp 关闭 桥FD 0示例:使用 VLAN 5 作为具有 VLAN 感知 Linux 网桥的 Proxmox VE 管理 IP自动定位 iface lo inet环回 iface eno1 inet 手册 自动vmbr0.5 iface vmbr0.5 inet 静态 地址10.10.10.2/24 网关10.10.10.1 自动虚拟机BR0 iface vmbr0 inet 手册 桥接端口 eno1 桥接 stp 关闭 桥FD 0 桥接 VLAN 感知 是 桥视频 2-4094

下一个示例是相同的设置,但使用绑定来使该网络实现故障安全。示例:使用带有 bond0 的 VLAN 5 作为具有传统 Linux 网桥的 Proxmox VE 管理 IP自动定位 iface lo inet环回 iface eno1 inet 手册 iface eno2 inet 手册 自动粘合0 iface bond0 inet 手册 债券奴隶 eno1 eno2 债券-米蒙 100 绑定模式 802.3ad bond-xmit-hash-policy 层 2+3 iface bond0.5 inet手册 自动 vmbr0v5 iface vmbr0v5 inet 静态 地址10.10.10.2/24 网关10.10.10.1 桥接端口 bond0.5 桥接 stp 关闭 桥FD 0 自动虚拟机BR0 iface vmbr0 inet 手册 桥接端口 bond0 桥接 stp 关闭 桥FD 0

3.3.9. 在节点上禁用 IPv6

Proxmox VE 在所有环境中都能正常工作,无论是否部署 IPv6。我们建议将所有设置保留为提供的默认值。

如果您仍然需要在节点上禁用对 IPv6 的支持,请通过创建适当的sysctl.conf (5)片段文件并设置适当的 sysctls来实现,例如添加/etc/sysctl.d/disable-ipv6.conf内容:net.ipv6.conf.all.disable_ipv6 = 1 net.ipv6.conf.default.disable_ipv6 = 1

此方法优于在 内核命令行上禁用 IPv6 模块的加载。

3.3.10. 禁用网桥上的 MAC 学习

默认情况下,网桥上启用 MAC 学习,以确保虚拟访客及其网络的流畅体验。

但在某些环境中,这可能是不受欢迎的。从 Proxmox VE 7.3 开始,您可以通过在“/etc/network/interfaces”中的网桥上设置“bridge-disable-mac-learning 1”配置来禁用网桥上的 MAC 学习,例如:# … 自动虚拟机BR0 iface vmbr0 inet 静态 地址10.10.10.2/24 网关10.10.10.1 桥接端口 ens18 桥接 stp 关闭 桥FD 0 桥接禁用 mac 学习 1

启用后,Proxmox VE 将手动将虚拟机和容器中配置的 MAC 地址添加到网桥转发数据库,以确保访客仍然可以使用网络 – 但仅限于他们使用实际 MAC 地址时。

3.4. 时间同步

Proxmox VE 集群堆栈本身在很大程度上依赖于所有节点都具有精确同步时间的事实。如果所有节点上的本地时间不同步,其他一些组件(例如 Ceph)也将无法正常工作。

节点之间的时间同步可以使用“网络时间协议”( NTP )来实现。从 Proxmox VE 7 开始,chrony被用作默认的 NTP 守护进程,而 Proxmox VE 6 使用systemd-timesyncd。两者都预先配置为使用一组公共服务器。

| 如果您将系统升级到 Proxmox VE 7,建议您手动安装chrony、ntp或openntpd。 |

3.4.1. 使用自定义 NTP 服务器

在某些情况下,可能需要使用非默认 NTP 服务器。例如,如果您的 Proxmox VE 节点由于限制性防火墙规则而无法访问公共互联网,则您需要设置本地 NTP 服务器并告诉 NTP 守护进程使用它们。

对于使用 chrony 的系统:

在/etc/chrony/chrony.conf中指定chrony应使用哪些服务器:服务器 ntp1.example.com iburst 服务器 ntp2.example.com iburst 服务器 ntp3.example.com iburst

重新启动计时:# systemctl 重新启动 chronyd

检查日志以确认正在使用新配置的 NTP 服务器:# Journalctl –since -1h -u chrony… 8 月 26 日 13:00:09 node1 systemd[1]:启动 chrony,一个 NTP 客户端/服务器。 8 月 26 日 13:00:15 node1 chronyd[4873]:选择源 10.0.0.1 (ntp1.example.com) 8 月 26 日 13:00:15 node1 chronyd[4873]:系统时钟 TAI 偏移设置为 37 秒 …

对于使用 systemd-timesyncd 的系统:

在/etc/systemd/timesyncd.conf中指定systemd-timesyncd应使用 哪些服务器:[时间] NTP=ntp1.example.com ntp2.example.com ntp3.example.com ntp4.example.com

然后,重新启动同步服务 ( systemctl restart systemd-timesyncd ),并通过检查日志 ( journalctl –since -1h -u systemd-timesyncd )来验证新配置的 NTP 服务器是否正在使用:… 10 月 7 日 14:58:36 node1 systemd[1]:停止网络时间同步… 10 月 7 日 14:58:36 node1 systemd[1]:开始网络时间同步… 10 月 7 日 14:58:36 node1 systemd[1]:开始网络时间同步。 10 月 7 日 14:58:36 node1 systemd-timesyncd[13514]:使用 NTP 服务器 10.0.0.1:123 (ntp1.example.com)。 10 月 7 日 14:58:36 node1 systemd-timesyncd[13514]:间隔/增量/延迟/抖动/漂移 64s/-0.002s/0.020s/0.000s/-31ppm …